Evolution de l'informatique

Dans cette page, je vais vous raconter l’évolution de l’informatique, à travers les technologies découverte au fur et à mesure du temps, par la découverte du transistor, et d’autres technologies, l’évolution des ordinateurs. Ce qui nous a donnée le monde de l’informatique de maintenant, avec Internet, les smartphones, les tablettes d’autres composant informatique.

Evolution de l'informatique

Née avec l'apparition des premiers ordinateurs à la fin de la seconde guerre mondiale, l'informatique eut tout d'abord pour mission de pallier les insuffisances humaines en matière de calcul numérique. Les ordinateurs devaient être alors capables de manipuler d'importantes masses de données dans un minimum de temps, faisant office de calculatrices électroniques performantes. Grâce aux progrès fulgurants en électronique et en automatisation, les machines se développèrent rapidement : depuis environ trente ans, elles offrent chaque année une puissance de calcul de 30 p. 100 supérieure à l'année précédente, pour un coût inversement proportionnel. Parallèlement à cette avancé technologique apparut dans les années 1950 une approche formelle de l'informatique en tant que science. Le mathématicien américain Norbert Wiener établit ainsi les fondements de la cybernétique, pendant qu'un autre mathématicien américain, Claude Elwood Shannon, élaborait la théorie de l'information.

L'informatique s'orienta rapidement dans une nouvelle direction lorsque l'on comprit que son domaine d'application pouvait s'étendre bien au-delà du simple calcul numérique. Dès lors, les ordinateurs furent conçus pour le traitement de l'information en général, tandis que se développaient les premiers langages de programmation adaptés aux problèmes de gestion, comme le langage COBOL. Dans les années 1960, les langages et les logiciels se multiplièrent, ainsi que les programmes assurant la gestion interne de la machine, toujours plus complexe. Les constructeurs furent alors confrontés à une situation délicate : malgré le progrès spectaculaire des techniques matérielles (hardware), les performances globales des systèmes informatiques n'évoluaient que très peu, en raison de la densité des techniques logicielles (software) installées sur chaque machine. Dans les années 1970, la microprogrammation se chargea donc de relayer les logiciels dans les opérations élémentaires de programmation, augmentant ainsi considérablement les performances de l'ordinateur.

Actuellement, l'industrie informatique axe ses recherches sur la miniaturisation des ordinateurs associés à des performances toujours plus élevées. De leur côté, les informaticiens théoriciens travaillent à une reproduction des mécanismes de la pensée par la machine, domaine de l'intelligence artificielle.

.png)

.png)

Les technologies de l'information

Au cœur du système technique contemporain, l'électronique permet la communication et le contrôle sans lesquels ce système ne fonctionnerait pas. Les technologies de l'information ont emprunté les composants disponibles à chaque époque : mécaniques dans les machines à calculer (Blaise Pascal, 1942) ou à écrire (vers 1870), dans les dispositifs électromécaniques puis électroniques. Les télécommunications par fil, télégraphe puis téléphone, se sont développées depuis la seconde moitié du XIX siècle en utilisant les dispositifs électromécaniques : relais, câbles, microphones, etc.

L'invention du tube électronique, en 1905, permit l'essor des télécommunications sans fil : radio et télévision à partir des années 1940. La course aux hautes fréquences ouvrit des applications variées : radar et radionavigation, faisceaux hertziens, etc. Le traitement de l'information et le calcul automatique suivirent la même évolution, avec un décalage de quelques dizaines d'années, les nombreuses pièces incorporées dans chaque machine devant être très faibles. Une industrie des machines comptables et des machines à cartes perforées (machine d'Hollerith, 1890) s'était développée depuis la fin du XIX siècle pour répondre aux besoins de contrôle et de gestion des grandes administrations (recensement, armées, finances) et des réseaux (chemins de fer). A la faveur de la Seconde Guerre Mondiale et des urgences qu'elle imposa, des ingénieurs britanniques et américains construisirent les premiers calculateurs électroniques (Colossus, 1943, ENIAC, 1945). L'idée de les programmer, non plus par des câblages matériels mais par des instructions symboliques enregistrées en mémoire, conduisit à la réalisation des premiers ordinateurs vers 1950, en Grande-Bretagne et aux Etats-Unis. L'industrie américaine s'imposa d'emblée, avec Univac et IBM au premier rang. Les composants étaient alors encore des pièces hétérogènes empruntées à des secteurs voisins : tubes radio, écrans et mémoires de radars.

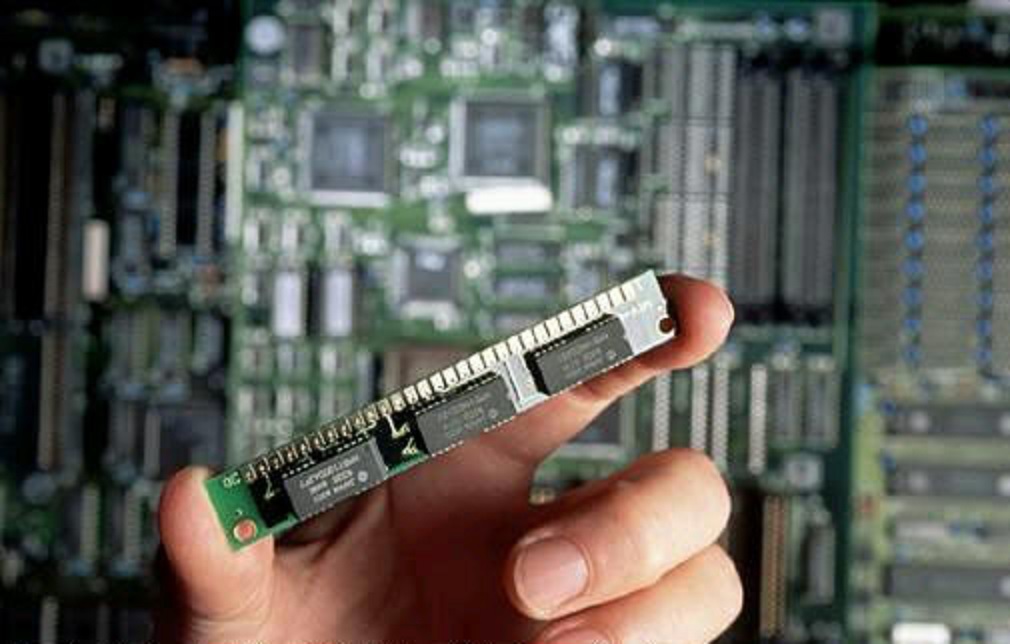

A partir de la fin des années 1950, ils furent supplantés par les semi-conducteurs : transistors (inventés en 1948 aux laboratoires Bell d'ATT), puis circuits intégrés. En 1973, la mise au point des premiers microprocesseurs (Intel 8008) permit de construire des micro-ordinateurs, qui allaient bouleverser l'industrie informatique et le monde du travail. Simultanément, les circuits intégrés furent jugés suffisamment fiables pour être utilisés dans les systèmes de télécommunications. Ceux-ci, jusque - l'analogiques, devinrent numériques et purent désormais être connectés avec les ordinateurs. Cette convergence de l'informatique et des télécommunications se manifesta par la mise en service de Transpac et du Minitel en France, d'Arpanet et d'Internet aux Etats-Unis puis dans le monde entier.

Dispositif électronique de traitement de l'information.

Le développement de l'informatique représente un atout majeur pour les progrès de la science. En particulier, il a permis de perfectionner les techniques utilisées en automatisation ainsi que les systèmes de communications. Aujourd'hui, les ordinateurs sont partout : selon leur puissance de calcul et leur capacité de stockage, on les utilise aussi bien pour gérer les données des gigantesques fichiers gouvernementaux, que pour mener à bien des programmes de recherche nécessitant de très grandes puissances de calcul, ou encore, plus modestement, pour tenir la comptabilité d'un ménage.

Ordinateurs numériques

Un ordinateur traite l'information sous forme codée : il convertit les données décimales en données binaires grâce à une série de commutateurs appelés aussi bascules, qui peuvent prendre seulement deux positions correspondant au 0 et au 1. Les opérations arithmétiques élémentaires s'effectuent au moyen de circuits logiques. La vitesse d'un ordinateur se mesure en gigahertz (GHz), c'est-à-dire en milliards de cycles par seconde. Un ordinateur dont la vitesse est de 10 GHz est donc capable d'exécuter au moins 10 milliards d'opérations par seconde. Les micro-ordinateurs de bureau peuvent effectuer plusieurs dizaines de millions d'opérations par seconde, tandis que les supercalculateurs, utilisés notamment en météorologie, ont des vitesses pouvant atteindre plusieurs milliards de gigahertz.

Premier calculateur

Les tous premiers calculateurs, ancêtres de l'ordinateur numérique, sont imaginés et réalisés au XVIIe siècle, en particulier par Wilhelm Schickard, Blaise Pascal et Leibniz. La machine de Pascal comporte une série de roues à dix crans, chaque cran représentant un chiffre de 0 à 9. Les additions et les soustractions s'effectuent en tournant les roues dentées d'un certain nombre de crans. Leibniz améliore par la suite cette machine en rajoutant un chariot mobile et une manivelle permettant d’accélérer et d’automatiser l’exécution des additions et des soustractions répétitives exigées par les multiplications et les divisions.

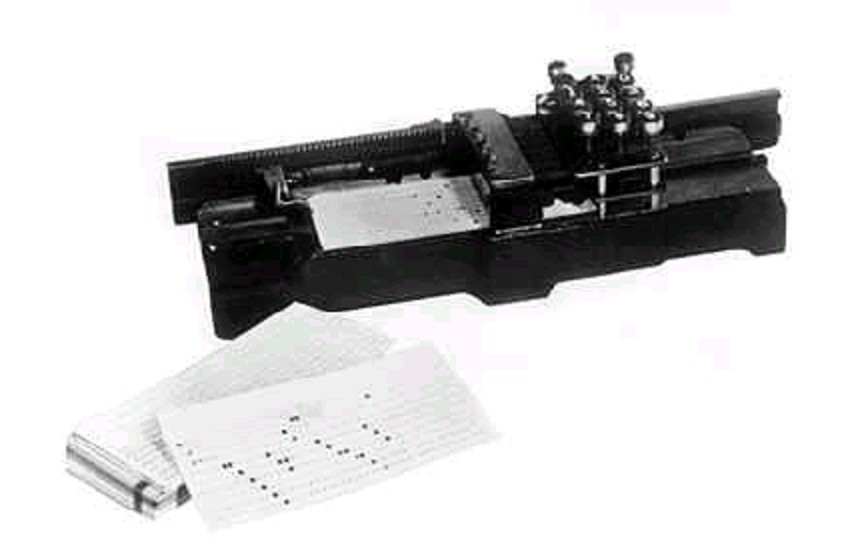

Au début du XIXe siècle, Joseph-Marie Jacquard conçoit un métier à tisser automatique en utilisant de fines plaques en bois perforées qui contrôlent le tissage de motifs compliqués. Puis, dans les années 1880, le statisticien américain Hermann Hollerith a l'idée d'utiliser des cartes perforées, similaires à celles de Jacquard, pour traiter des données. En utilisant un système où les cartes perforées passent sur des contacts électriques, il parvient à compiler des informations statistiques pour le recensement de la population des États-Unis en 1890. En 1896, il fonde la Tabulating Machine Corporation, qui deviendra, par la suite, la société IBM.

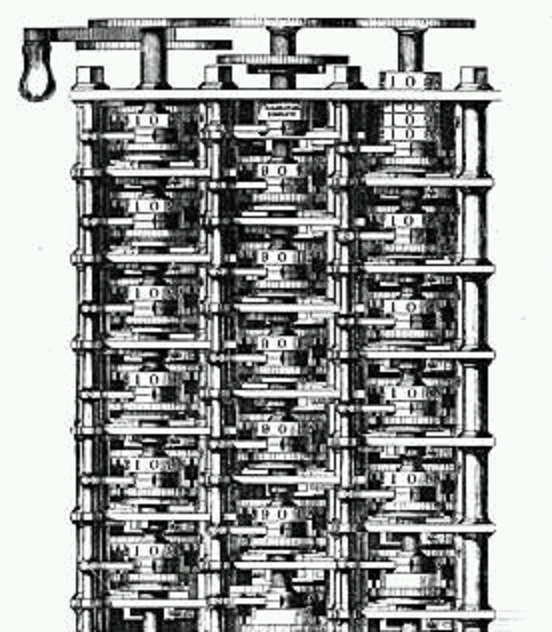

Machines différentielle et analytique

Au XIXe siècle, le mathématicien et inventeur britannique Charles Babbage découvre les principes de l'ordinateur numérique moderne, en faisant le rapprochement entre les machines à calculer et les systèmes de commande automatique de Jacquard. Il crée différentes machines, en particulier la machine différentielle et la machine analytique. Il entreprend tout d’abord, en 1822, la construction de la machine différentielle, destinée à résoudre des problèmes mathématiques avec une précision de vingt décimales. Mais après dix années de travail acharné, les subventions de l’État et de la Royal Society sont suspendues et Babagge doit abandonner son projet. En 1833, Babbage se lance alors dans un nouveau projet : la machine analytique, dont une partie seulement sera réalisée. Véritable précurseur de l’ordinateur moderne, cette machine aurait été capable de stocker des instructions, d'exécuter des opérations mathématiques et d'utiliser des cartes perforées comme support de mémoire. La plupart des historiens considèrent Babbage comme le véritable inventeur de l'ordinateur numérique moderne, même si la technologie peu avancée de l'époque l'a empêché de réaliser concrètement ses idées.

Premiers ordinateurs

Les premiers ordinateurs analogiques sont fabriqués au début du XXe siècle. Ils effectuent leurs calculs grâce à un système d'axes et d'engrenages. Ce type de machine permet de fournir des approximations numériques d'équations difficiles à résoudre autrement. Pendant les deux guerres mondiales, des systèmes analogiques mécaniques, puis électriques, sont notamment utilisés comme pointeurs de torpille dans les sous-marins et comme contrôleurs de visée dans les bombardiers.

Ordinateurs électroniques

Dès 1939, un prototype de machine électronique est fabriqué aux États-Unis par John Atanasoff et Clifford Berry à l'Iowa State College. Ce prototype, discrètement développé, est éclipsé par la présentation en 1945 de l'ENIAC (Electronic Numerical Integrator And Computer), machine programmable, numérique, basée sur le système décimal, et entièrement électronique, conçu par Eckert et Mauchly. L'ENIAC contient 18 000 tubes à vide, pèse environ 30 tonne, et peut effectuer plusieurs centaines de calculs par minute. Son programme est connecté au processeur, mais il doit être modifié manuellement. Pour cette raison et en dépit de ses qualités indéniables, l’ENIAC n’est pas considéré comme le premier ordinateur, au sens actuel du terme.

Parallèlement, à Londres, pendant la Seconde Guerre mondiale, est mis au point Colossus, un ordinateur numérique entièrement électronique, basé sur le concept de la machine « intelligente » proposée en 1936 par le logicien visionnaire Alan Turing. Élaboré par une équipe de physiciens et de mathématiciens dirigée par Turing, Colossus est opérationnel en décembre 1943. Comportant 1 500 tubes à vide, il est utilisé pour déchiffrer les messages radio codés des Allemands.

Vers la fin de l’année quarante-cinq, le mathématicien américain John von Neumann, qui avait été consultant sur le projet ENIAC, propose la construction de l’EDVAC, machine qui préfigure les caractéristiques de l’ordinateur moderne. En effet, la machine de von Neumann est la première à utiliser un programme mémorisé. Les instructions sont stockées dans une mémoire, évitant à l'ordinateur d'être soumis à la vitesse limitée du lecteur de bande-papier pendant l'exécution du programme. Ce dispositif de stockage supprime également la réinstallation contraignante de l'ordinateur à chaque nouveau programme.

À la fin des années cinquante sont conçus des ordinateurs dits de deuxième génération, dans lesquels les tubes à vide sont remplacés par des transistors. Ces derniers, plus durables et plus économiques, permettent de développer des éléments logiques plus petits, plus rapides, plus souples et dont le coût de fabrication est moins élevé.

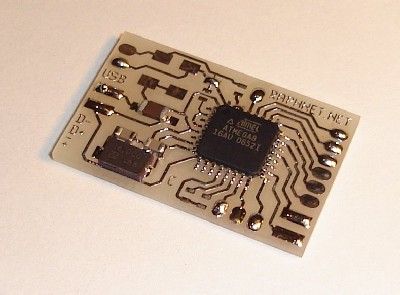

Circuits intégrés

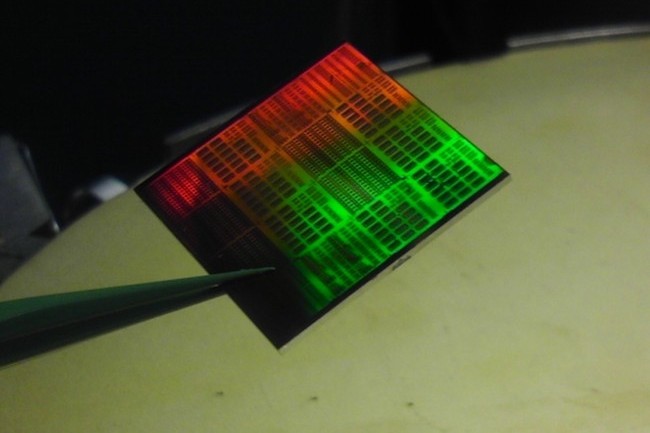

À la fin des années soixante, l'utilisation des circuits intégrés permet de graver un nombre important de transistors sur un seul substrat de silicium, reliés par des fils d'interconnexion blindés. Puis, au milieu des années soixante-dix, apparaît le processeur miniaturisé ou microprocesseur, grâce à l'élaboration des circuits intégrés à grande échelle (LSI), puis des circuits intégrés à très grande échelle (VLSI). Un microprocesseur est un processeur constitué d'un seul circuit intégré, sur lequel sont gravés plusieurs milliers de transistors interconnectés.

Les ordinateurs des années soixante-dix sont généralement capables de gérer simultanément 8 commutateurs. Ils peuvent donc reconnaître 8 chiffres binaires, ou bits de données, pendant chaque cycle. Un registre de 8 bits est appelé octet, et celui-ci peut donc adopter 256 configurations différentes de ON (activé) et de OFF (désactivé) (soit de 1 et de 0). Chaque configuration correspond à une instruction, à une partie d'instruction, ou à un type particulier de donnée : un nombre, un caractère ou un symbole graphique.

Puis, au fil des ans sont mis au point des microprocesseurs capables de gérer simultanément 16, 32, puis 64 bits de données, ce qui permet d'augmenter la rapidité et la puissance des ordinateurs. Aujourd'hui, le développement des ordinateurs s'effectue globalement dans deux directions : une taille toujours plus réduite et une puissance toujours plus grande.

Matériel

Tous les ordinateurs numériques modernes sont de conception similaire ; néanmoins, on peut les classer en différentes catégories suivant leur prix et leurs performances. Un ordinateur personnel, ou micro-ordinateur, est une machine relativement peu onéreuse, généralement conçue pour un bureau ou portable. Une station de travail est un micro-ordinateur disposant d'outils graphiques et de communication avancés, qui en font l'outil idéal pour accomplir des tâches nécessitant à la fois de bonnes capacités de stockage et de puissance de calcul. Enfin, un supercalculateur est une machine capable de répondre aux besoins de grandes entreprises commerciales, des différentes institutions gouvernementales ou militaires et des établissements de recherche scientifique.

Unité centrale de traitement

Appelée également CPU (Central Processing Unit), cette unité est composée d'une ou plusieurs puces (groupe de circuits intégrés contenant un microprocesseur), qui effectuent les calculs arithmétiques et logiques, et qui régulent et contrôlent les opérations des autres éléments du système.

Les puces de traitement et les microprocesseurs sont généralement composés de quatre unités fonctionnelles : une unité arithmétique et logique, des registres, une unité de contrôle et un bus interne.

L'unité arithmétique et logique permet d'effectuer les opérations arithmétiques, comparatives et logiques. Les registres sont des zones de stockage temporaires qui conservent les données, sauvegardent les instructions et gèrent les adresses (valeurs représentant des zones définies de mémoire), ainsi que les résultats des opérations. L'unité de contrôle remplit trois tâches principales : elle réglemente toutes les opérations du système informatique ; elle lit et traduit les configurations des données ; enfin, elle indique l'ordre dans lequel les opérations individuelles sont traitées, et calcule le temps que chacune d'entre elles requiert à l'unité de traitement. Enfin, le bus interne est un ensemble de circuits chargé d'assurer l'acheminement des données et des signaux de contrôle entre le microprocesseur, ses circuits annexes et la mémoire. Ce bus est généralement divisé en trois régions : le bus de contrôle qui transporte les signaux de contrôle garantissant le bon fonctionnement du microprocesseur, le bus d'adresse qui véhicule les adresses mémoire et le bus de données, autoroute bidirectionnelle qui assure le transport des données.

Unités de stockage

Les systèmes informatiques peuvent stocker des données de manière temporaire ou permanente. La mémoire vive (RAM) sert de stockage temporaire au microprocesseur pour les programmes, le travail en cours et différentes informations internes de contrôle des tâches. La mémoire morte (ROM) est au contraire un support permanent et non effaçable pour la conservation d'informations utiles, notamment les informations de démarrage et les procédures d'entrée / sortie. Voir mémoire (informatique). Un ordinateur possède également d'autres types de stockage qui conservent l'information de manière quasi permanente comme les disquettes, les disques durs, ou encore les bandes magnétiques. Ces unités, qui stockent les données sur un support magnétique sensible, peuvent contenir de plusieurs centaines de milliers à plus d'un million d'octets de données pour les disquettes, et de plusieurs millions à des centaines de millions d'octets pour les disques durs. Il existe également des supports de stockage non magnétiques comme les disques compacts (CD-ROM), dont la lecture est assurée grâce à un faisceau laser. Ces derniers disposent d'une capacité de stockage de plusieurs giga-octets (milliards d'octets) de données.

Bus

Le bus est un ensemble de conducteurs parallèles servant au transfert d'informations entre les composants d'un ordinateur. Il peut être comparé à une autoroute reliant les différentes parties du système informatique qui se la partagent pour échanger des données. En général supervisé par le microprocesseur, un bus est souvent spécialisé dans le type d'information qu'il transfère. Ainsi, un groupe de circuits transporte les données, un autre transporte les adresses, un autre encore véhicule les informations de contrôle qui assurent que chaque partie du système utilise bien la partie d'autoroute qui lui est réservée. Les bus se distinguent également par le nombre de bits qu'ils transportent en parallèle. Un bus 8-bits véhicule 8 bits (soit 1 octet) d'informations à la fois, donc un bus 16-bits transporte 2 octets. Le bus est partie intégrante de l'ordinateur, mais comme certains dispositifs additionnels ont besoin d'accéder directement au système, il est prévu des broches d'extension directement connectées au bus.

Programmation

Un programme souvent appelé logiciel (software), est une séquence d'instructions qui indique au matériel informatique (hardware) les opérations qu'il doit effectuer sur les données. Les programmes peuvent être intégrés au hardware, comme sur les micro-ordinateurs que l'on trouve dans les calculatrices, les montres, les moteurs automobiles ou les fours à micro-ondes. Sur un ordinateur classique coexistent deux types de logiciel, selon le type de tâche qu'ils exécutent. Les logiciels d'application prennent en charge la multitude des tâches pour lesquelles sont utilisés les ordinateurs : traitement de texte, gestion de bases de données, etc. Les logiciels système, qui sont souvent invisibles à l'utilisateur, contrôlent le fonctionnement de l'ordinateur : on les appelle systèmes d'exploitation.

Systèmes d'exploitation

Les systèmes d'exploitation gèrent l'allocation et l'utilisation des ressources matérielles de l'ordinateur, telles que la mémoire, l'unité centrale de traitement, l'espace du disque dur et les périphériques (imprimante, manette de jeu, modem, etc.). Ce sont des logiciels stockés de façon permanente dans la mémoire, qui interprètent les commandes de l'utilisateur suivant le service qu'il désire : afficher, imprimer ou copier des fichiers de données, lister tous les fichiers d'un répertoire, ou encore exécuter un programme particulier.